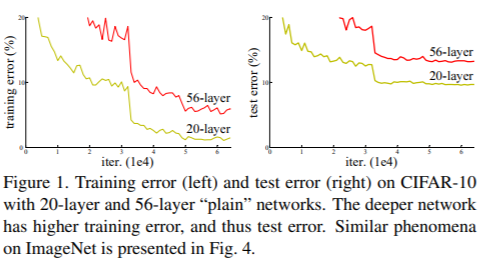

https://arxiv.org/pdf/1512.03385.pdf 초록 딥러닝에서 neural networks가 깊어질수록 성능은 더 좋지만 train이 어렵습니다. 그래서 이 논문에서는 잔차를 이용한 잔차학습 (residual learning framework)를 이용해서 깊은 신경망에서도 training이 쉽게 이뤄질 수 있다는 것을 보이고 방법론을 제시했습니다. 함수를 새로 만드는 방법 대신에 residual function, 잔차 함수를 learing에 사용하는 것으로 layer를 재구성합니다. 결과적으로 152개의 layer를 쌓아서 기존의 VGG net보다 좋은 성능을 내면서 복잡성은 줄였습니다. 소개 딥러닝에서 layer가 더 깊어지면 깊어질수록 모델의 accuracy가 saturating되..